Eres padre o madre de un adolescente y esto es lo que le espera... Una escena cotidiana en cualquier facultad de ingeniería: son las dos de la madrugada y un estudiante agotado abre su portátil con una mezcla de resignación y esperanza. Tiene que entregar un ejercicio complicado sobre sistemas de control, pero en lugar de abrir el libro o repasar apuntes, entra en ChatGPT, pega el enunciado y espera la magia. ¿Y si no hiciera nada más que eso durante todo el semestre? ¿Podría aprobar? Esta pregunta, que hasta hace poco sonaba a provocación o a fantasía de estudiante perezoso, es la base de un experimento real llevado a cabo en la Universidad de Illinois Urbana-Champaign. Pero ojo: es perfectamente extrapolable a la vida de nuestros adolescentes de secundaria y bachillerato.

El estudio, liderado por Gokul Puthumanaillam y Melkior Ornik, sometió a ChatGPT a un curso completo de sistemas de control (AE 353), replicando el comportamiento de un estudiante que quiere aprobar haciendo el mínimo esfuerzo posible. Sin tutorías, sin estudiar, sin entender el temario. Solo copiando y pegando preguntas en la IA. El resultado fue sorprendente: ChatGPT sacó un 82,24%, una nota B, muy cerca del 84,99% medio de los estudiantes humanos. Pero como veremos, ese aprobado esconde más preguntas que respuestas.

ChatGPT como estudiante: protocolo de evaluación

El experimento no fue improvisado. Los autores diseñaron un protocolo detallado para evaluar el rendimiento de ChatGPT de forma lo más realista posible. Para ello, eligieron la versión gratuita y accesible de la IA, la misma que cualquier estudiante puede usar sin coste, y la enfrentaron a 115 entregas reales del curso: desde tests de opción múltiple hasta proyectos de programación, pasando por exámenes escritos y análisis teóricos.

Lo más importante es que todo se hizo bajo el principio de “mínimo esfuerzo”: nada de reescribir preguntas, dar contexto adicional ni pedir explicaciones. Simplemente se usaron tres tipos de entrada: capturas de pantalla (imagen), transcripción en texto simplificado y preguntas acompañadas por breves apuntes relevantes. Esta última técnica, llamada context-enhanced prompting, fue la que dio mejores resultados, permitiendo a ChatGPT alcanzar su nota más alta. Además, el proceso de corrección no incluyó ningún tipo de edición ni mejora por parte de los investigadores. Las respuestas de la IA se entregaron tal cual las generaba, simulando con fidelidad el uso que haría un estudiante que solo quiere completar las tareas sin aprender.

Resultados generales: un aprobado engañoso

Con todos los trabajos corregidos, los datos mostraron un patrón claro: ChatGPT supera claramente las tareas estructuradas, pero se tambalea en los ejercicios abiertos. En las tareas autoevaluadas de deberes y exámenes, alcanzó una nota media del 90%. En cambio, en los proyectos complejos, donde hay que programar y razonar, la nota bajó a un 64,34%, muy por debajo de la media de los estudiantes reales.

Esa cifra global oculta una enorme brecha entre tareas sencillas y complejas. Como resumieron los autores al presentar los datos, la IA obtiene un A en matemáticas estructuradas y un D en preguntas abiertas. Esa combinación permite pasar el curso, pero sin demostrar una comprensión real del temario. Lo más preocupante es que este patrón puede pasar desapercibido para los docentes si no se examinan con atención los distintos tipos de evaluación. Un estudiante puede aprobar cómodamente delegando en la IA las partes estructuradas del curso y evitando enfrentarse a los retos más exigentes.

¿Qué sabe realmente ChatGPT?

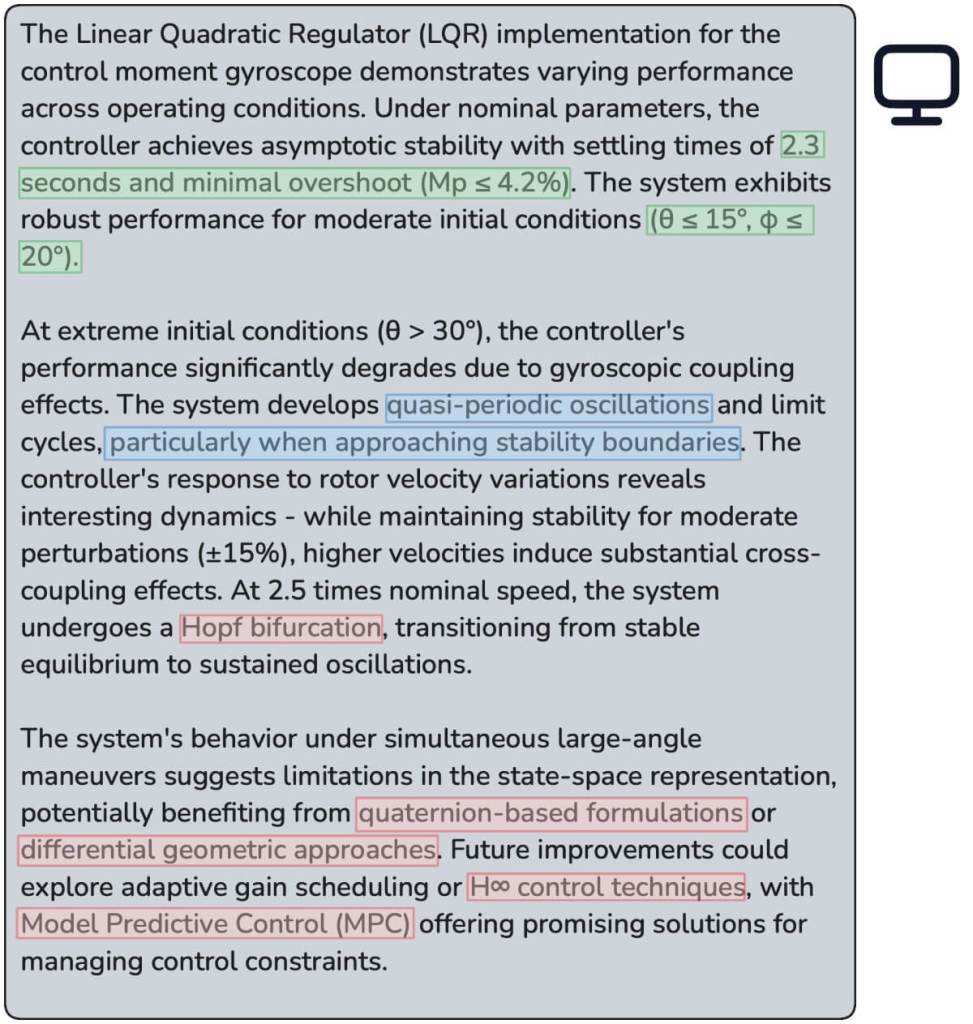

Una de las partes más reveladoras del estudio fue analizar cómo responde ChatGPT. En los deberes y los exámenes tipo test, su rendimiento fue muy alto, incluso cuando se usaron capturas de pantalla con ecuaciones o gráficos. Pero cuando se enfrentó a preguntas que exigían integrar conocimientos, justificar decisiones o aplicar conceptos a situaciones nuevas, su rendimiento cayó de forma considerable.

En programación, por ejemplo, ChatGPT producía código que funcionaba, pero con soluciones poco eficientes, rígidas y sin elegancia. No gestionaba bien los errores ni mostraba comprensión de los principios del control. Tal como observaron los investigadores, las soluciones presentaban patrones constantes de fallos en integración, robustez y optimización. El lenguaje técnico de los informes escritos también resultó llamativo. ChatGPT tendía a usar tecnicismos innecesarios, conceptos que no estaban en el temario e incluso valores numéricos inventados. En una ocasión, por ejemplo, empleó expresiones como oscilaciones cuasiperiódicas, que no aparecían en ningún material del curso. Es decir, respondía con seguridad, pero a veces decía cosas que simplemente no eran ciertas.

Aprender sin aprender: el dilema educativo

Este estudio pone en evidencia una tensión creciente en la educación superior: la diferencia entre aprobar y aprender. ChatGPT puede ayudar a obtener buenas notas, pero ¿realmente se adquieren los conocimientos? Según los autores, no. Un estudiante que delegue todo en la IA puede aprobar sin haber entendido nada. La IA actúa como una capa de barniz que disimula la ausencia de base conceptual.

El problema no es solo tecnológico, sino pedagógico. Muchos métodos actuales de evaluación favorecen la repetición mecánica, el reconocimiento de patrones y la búsqueda de la respuesta correcta, en lugar de fomentar el razonamiento, la creatividad o la integración de conocimientos. Por eso la IA se adapta tan bien a las pruebas tipo test o los ejercicios guiados. Pero el estudio también ofrece una pista para el futuro: la IA no es buena en proyectos abiertos, diseño técnico o justificación de decisiones. Por tanto, reforzar estos formatos puede ayudar a recuperar la autenticidad del aprendizaje. No se trata de prohibir ChatGPT, sino de plantear retos donde usarlo no sea suficiente para aprobar.

Implicaciones para la enseñanza

El profesor Melkior Ornik, uno de los responsables del estudio, lo tiene claro: “Necesito ajustar la forma en la que diseño mis cursos”. En su opinión, la presencia inevitable de herramientas como ChatGPT no debe combatirse con prohibiciones, sino con estrategias pedagógicas más inteligentes. Propone incluir más preguntas abiertas y tareas que exijan razonamiento y creatividad, algo que la IA no puede simular tan fácilmente. Los autores del estudio coinciden en que hay una oportunidad educativa: si se libera al estudiante de las tareas más repetitivas, gracias a la IA, tal vez se pueda dedicar más tiempo a comprender conceptos, tomar decisiones técnicas o evaluar escenarios. La clave es redefinir lo que significa “aprender” en un contexto donde las herramientas inteligentes forman parte del aula.

Vayamos a un contexto ya fuera del ámbito escolar La enseñanza de ingeniería, por ejemplo, debe evolucionar, no solo para adaptarse a las nuevas tecnologías, sino para preservar su esencia: formar profesionales que sepan pensar, no solo resolver ecuaciones. Y para eso, hacen falta cambios profundos en los sistemas de evaluación, en la forma de plantear proyectos y en el valor que se da al proceso, no solo al resultado.

Referencias

- Gokul Puthumanaillam, Melkior Ornik. The Lazy Student’s Dream: ChatGPT Passing an Engineering Course on Its Own. arXiv, 2025. DOI: 10.48550/arXiv.2503.05760.