Con la inteligencia artificial y la tecnología como grandes protagonistas de los tiempos que corren, y teniendo en cuenta que ya están impactando en disciplinas relacionadas con la crianza como la educación o la pediatría, ¿te has preguntado alguna vez si puede un robot leer las emociones de tu hijo o hija mejor que tú?

La pregunta viene al caso aunque te pueda parecer un disparate porque el aula del futuro ya está aquí: asistentes virtuales que responden con voz dulce, robots que detectan emociones con cámaras y sensores, o algoritmos que adaptan juegos según el humor del niño son una realidad. Otra cosa bien distinta es cómo influyan y afecten a la educación o al ámbito de la crianza en el caso de la familia. Pero no cabe duda de que este contexto lleva de forma inevitable a hacerse preguntas como la que te hacíamos en la entradilla.

Preguntas es lo que se han hecho los investigadores de un estudio publicado en la revista científica AI, Brain and Child. Por ejemplo, han intentado medir cuál es el impacto real tienen estos dispositivos, en especial la IA, en el desarrollo de niñas y niños menores de ocho años.

Sus conclusiones comparten una advertencia clara: introducir inteligencia artificial en la educación infantil puede poner en riesgo la privacidad, la autonomía y el desarrollo emocional de los menores si no se hace bajo marcos éticos sólidos y diseñados desde la infancia.

¿En qué ha consistido el estudio?

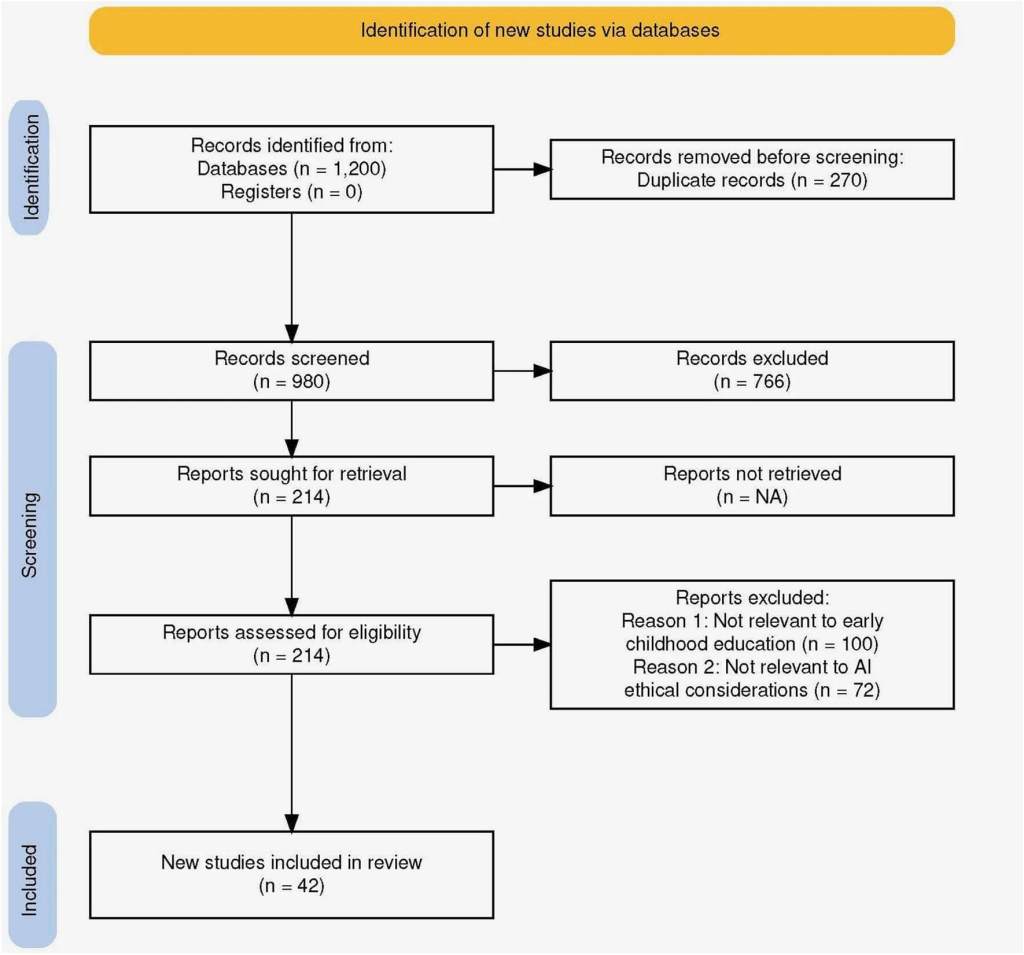

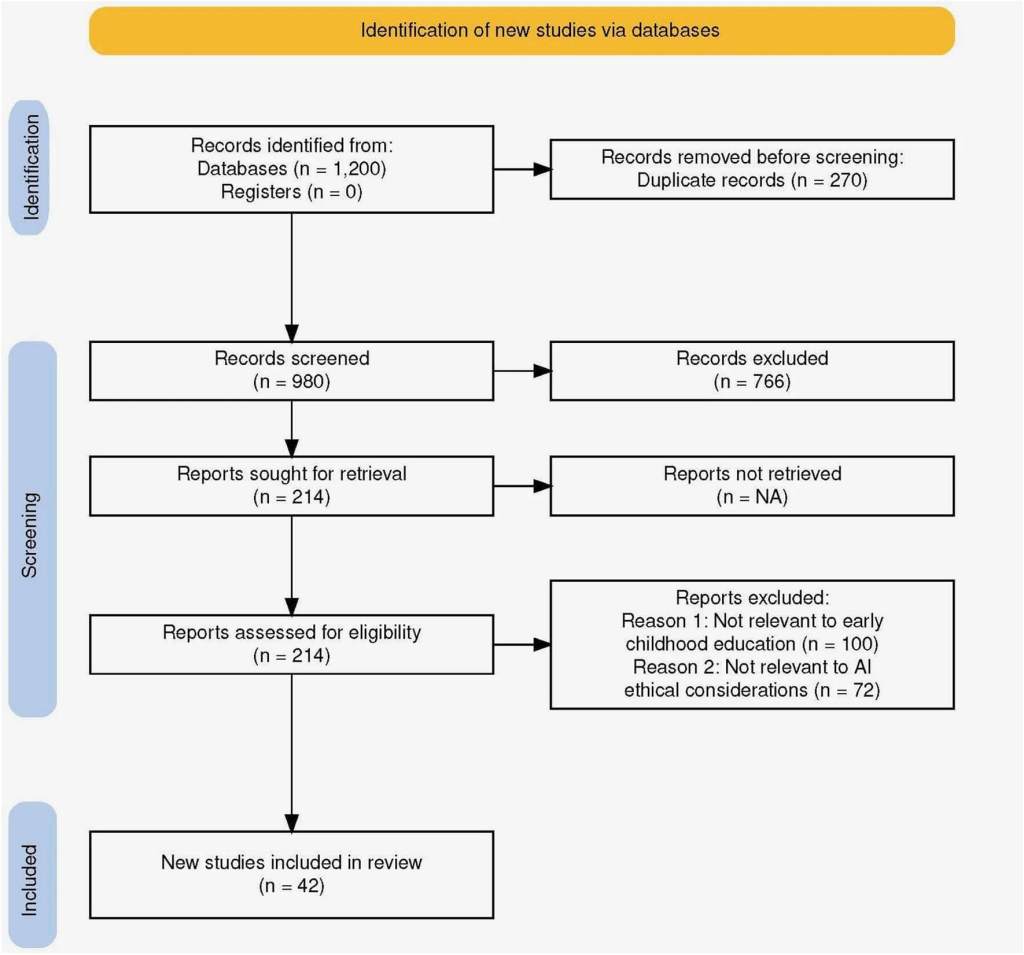

La investigación, liderada por Ilene R. Berson y Michael J. Berson (Universidad del Sur de Florida) junto con Wenwei Luo (Universidad Normal de Shanghái), analiza 42 estudios previos sobre el uso de IA en educación infantil. Y sus conclusiones, lejos del entusiasmo tecnológico habitual, piden prudencia: los beneficios son reales, pero los peligros también. Y en los niños más pequeños, esos peligros pueden pasar completamente desapercibidos.

El equipo de investigadores llevó a cabo una revisión exhaustiva de 42 estudios internacionales publicados entre 2015 y 2024 sobre inteligencia artificial aplicada en la etapa de 0 a 8 años. Seleccionaron trabajos que abordaban tres grandes áreas de preocupación: privacidad de datos, impacto en el desarrollo infantil y sesgo algorítmico. A este análisis sumaron una categoría emergente: la falta de marcos regulatorios y éticos consistentes.

Se centraron especialmente en tecnologías como robots educativos, asistentes conversacionales y sistemas de reconocimiento emocional que se están incorporando tanto en escuelas como en juguetes y aplicaciones domésticas.

Uno de los grandes aportes del estudio es cómo contextualiza el desarrollo infantil. Los autores insisten en que la etapa de 0 a 8 años requiere entornos basados en el juego libre, la interacción social y la exploración sensorial. Muchos sistemas de IA, sin embargo, están pensados para maximizar la eficiencia académica, sin tener en cuenta estos pilares del aprendizaje temprano.

Principales hallazgos y cómo afectan a la crianza y educación

Estos son los hallazgos más interesantes y trascendentes de esta investigación publicada este mismo mes de mayo de 2025:

Relaciones emocionales distorsionadas

Uno de los aspectos más inquietantes del informe es el rol de los robots que imitan emociones humanas. Al responder con gestos, voces o expresiones programadas, estos dispositivos pueden generar apego parasocial en los niños: vínculos emocionales con seres que no sienten ni comprenden. Esto puede afectar el desarrollo empático y las habilidades sociales.

Los niños y niñas pequeños, especialmente menores de cinco años, aún no distinguen entre lo real y lo simulado. Según el estudio, esto puede llevar a que confíen más en un robot que en un adulto, compartan información sensible, o incluso cambien su comportamiento para “gustarle” a la máquina.

Privacidad infantil en riesgo

Los dispositivos que analizan emociones (mediante voz, mirada o expresión facial) recopilan datos altamente sensibles. Estos datos, si no están bien protegidos, pueden ser utilizados con fines comerciales o almacenarse sin el conocimiento de las familias. El informe denuncia la falta de transparencia de muchos sistemas educativos basados en IA, y la ausencia de controles adaptados a la infancia.

Los expertos proponen aplicar el principio de “privacidad desde el diseño”, donde la seguridad y la transparencia estén incorporadas desde el inicio, con interfaces adaptadas para padres, niñas y niños.

Diseños no adecuados al desarrollo infantil

Muchos productos con IA están pensados para niños mayores o adolescentes, y no consideran la etapa de aprendizaje simbólico y motor del primer ciclo de educación infantil. Interfaces que requieren atención prolongada o interacciones rígidas pueden limitar el juego libre o la creatividad.

Además, el estudio recomienda fomentar el juego digital intergeneracional, donde madres, padres o educadores participen activamente junto a los niños. Esto no solo protege, sino que también enriquece el vínculo afectivo, como ya abordamos en este artículo sobre el robot que cambió la comunicación entre padres e hijos.

Sesgos que refuerzan desigualdades

Los algoritmos de IA se entrenan con datos previos. Si esos datos no reflejan la diversidad cultural, lingüística o socioeconómica de los niños y niñas, pueden generar errores o sesgos. Por ejemplo, un niño o niña que no hable el idioma principal o tenga otro estilo de aprendizaje puede ser mal evaluado o clasificado como “problemático” por un sistema automatizado. En esto, el ser humano todavía va muy por delante de la inteligencia artificial: otro estudio reciente ha demostrado que los niños son capaces de entender emociones en otro idioma sin conocer ni una sola palabra de este.

Este aspecto es especialmente grave en contextos vulnerables, donde la IA se presenta como solución a la falta de docentes, pero sin adaptarse a la realidad del alumnado.

Hacia una IA ética y respetuosa con la infancia

El estudio propone, más allá de sus hallazgos y de las reflexiones que estos suscitan, una hoja de ruta clara: si vamos a introducir inteligencia artificial en la vida de los más pequeños, debe hacerse de manera ética, participativa y con pleno respeto a sus derechos.

Los investigadores insisten en la necesidad de crear marcos legales específicos para la infancia, que aseguren la transparencia en el uso de datos, el control parental, la alfabetización digital temprana y la supervisión de los vínculos que niños y niñas establecen con estas tecnologías.

También recomiendan que padres y madres estén informados y puedan participar en el diseño y la elección de los sistemas que usan sus hijos, algo que podría articularse a través de formaciones específicas o espacios compartidos en el entorno educativo.

Referencias

- Ilene R. Berson, Michael J. Berson, Wenwei Luo. Innovating responsibly: ethical considerations for AI in early childhood education. AI, Brain and Child, 2025. DOI: 10.1007/s44436-025-00003-5