¿Qué pasa cuando un niño de siete años cuenta algo importante a un adulto? En muchos casos, incluso sin querer, los adultos interfieren: interrumpen, reformulan, completan. Y si ese adulto no ha recibido formación para entrevistar a menores en situaciones delicadas —como presenciar un abuso—, la calidad de la información obtenida puede verse gravemente afectada. No es por falta de buena intención, sino por las limitaciones inherentes al lenguaje adulto-niño. Ahora, una nueva investigación plantea un giro inesperado: ¿y si una inteligencia artificial (IA) formulando preguntas lograra mejores resultados que un humano sin formación especializada?

Un estudio recién publicado en PLOS ONE lo demuestra. El equipo, liderado por investigadores de la Universidad de Nueva York en Shanghái y la Universidad Åbo Akademi de Finlandia, comparó el desempeño de un modelo de lenguaje avanzado (ChatGPT) con entrevistadores humanos sin experiencia en entrevistas forenses. La conclusión fue tan clara como prometedora: el modelo de IA fue más eficaz a la hora de formular preguntas que ayudaran a los niños a contar lo que habían presenciado con precisión, y con menos errores.

IA versus intuición: ¿quién pregunta mejor?

La investigación partió de una hipótesis ambiciosa: que un gran modelo de lenguaje, bien afinado y guiado por buenas prácticas, podría superar a adultos sin entrenamiento específico a la hora de entrevistar a niños sobre un evento presenciado. Para comprobarlo, 78 niños de entre 6 y 8 años vieron un breve video que contenía una escena ambigua: una interacción entre un adulto y un menor que, en otros contextos, podría malinterpretarse como inapropiada o incluso abusiva.

Luego, cada niño fue entrevistado por una de dos condiciones: un adulto sin formación en entrevistas a menores, o bien una inteligencia artificial que generaba las preguntas en tiempo real, leídas por un asistente humano. El objetivo no era solo obtener información correcta, sino hacerlo sin inducir a errores ni sugestionar a los menores.

Uno de los hallazgos clave fue que la IA formuló preguntas más eficientes, obteniendo más información única por cada pregunta realizada. Como señalan los autores, “LLM (vs. humans) also elicited less false information overall, but there was no difference in false information elicited per question.”

Las buenas preguntas importan (y mucho)

En este tipo de entrevistas, no todas las preguntas valen lo mismo. Las mejores son las abiertas, como “¿Qué pasó?” o “Cuéntame todo lo que recuerdas”. Estas invitan al niño a reconstruir el relato desde su punto de vista, sin condicionarlo. Por el contrario, preguntas cerradas o sugerentes —como “¿Te tocó?” o “Eso debió doler, ¿verdad?”— aumentan el riesgo de obtener información incorrecta o inducida.

El estudio evaluó cada tipo de pregunta formulada por humanos e IA. Aunque los entrevistadores humanos formularon más preguntas en total, una buena parte de ellas no cumplía con las recomendaciones. La IA, en cambio, mantuvo una proporción alta de preguntas abiertas o directivas (también aceptadas dentro del protocolo forense), y evitó más eficazmente las sugerentes o inadecuadas.

Como concluye el artículo: “No hubo diferencias entre el LLM y los entrevistadores humanos en la información correcta única obtenida, pero las preguntas formuladas por el LLM (en comparación con los humanos) obtuvieron más información correcta única por pregunta”.

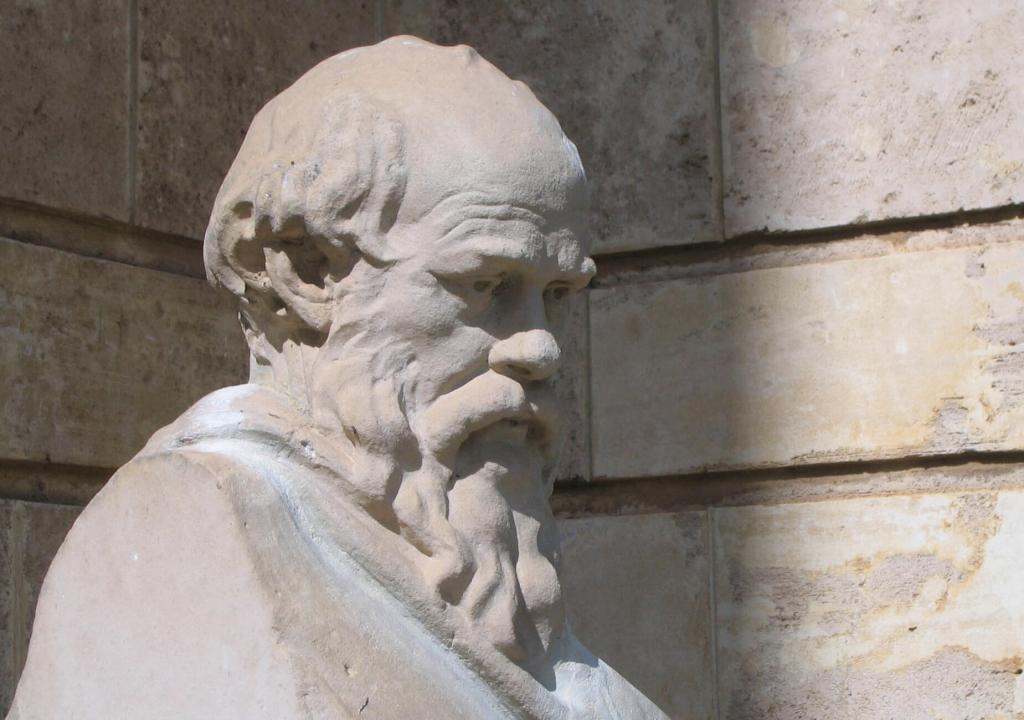

Una IA con espíritu socrático

La forma en que esta inteligencia artificial entrevista a los niños recuerda poderosamente al método mayéutico de Sócrates. En la Antigua Grecia, el filósofo no enseñaba en el sentido tradicional, sino que ayudaba a sus interlocutores a descubrir por sí mismos lo que sabían sin saber que lo sabían. Lo hacía a través de preguntas abiertas, sin imponer respuestas. Esta técnica, conocida como mayéutica —del griego maieutiké, el arte de asistir en el parto— buscaba que el conocimiento emergiera desde el interior de cada persona, como si el filósofo solo facilitara su nacimiento.

Algo similar ocurre con los modelos de IA bien entrenados para entrevistas con niños. No interrogan, no suponen ni corrigen. Preguntan con precisión, sin dirigir ni inducir. Formulan cuestiones como “¿Qué pasó después?”, “¿Puedes contarme más sobre eso?”, o “¿Cómo era la persona que viste?”. Estas preguntas, igual que las de Sócrates, no buscan confirmar una hipótesis ni señalar una verdad preconcebida, sino abrir el espacio para que el niño reconstruya sus recuerdos con libertad y seguridad. Esto resulta especialmente valioso en contextos sensibles, donde la sugerencia o el sesgo pueden distorsionar gravemente los relatos.

Los investigadores del estudio destacan que los modelos de lenguaje utilizan mejor que los humanos sin formación las preguntas recomendadas por la literatura científica, lo que los acerca aún más al enfoque socrático. Si Sócrates decía que el buen maestro no enseña, sino que acompaña, esta IA puede considerarse una especie de maestro invisible: uno que no da respuestas, sino que hace las preguntas adecuadas para que el otro encuentre las suyas.

Niños, IA y naturalidad

Un dato curioso: al final de las entrevistas, se preguntó a los niños si creían que las preguntas habían sido hechas por una persona o por una computadora. La mayoría pensó que provenían de un ser humano. Esto sugiere que la naturalidad de las preguntas generadas por IA era suficiente como para pasar desapercibida, lo cual es un punto a favor en situaciones en las que mantener el rapport con el menor es clave.

El 61% de los niños creyó que las preguntas eran humanas, y este dato no influyó significativamente en la calidad de sus respuestas. La percepción de la autenticidad no alteró la proporción de información verdadera o falsa aportada por los niños.

IA que escucha, piensa… y espera

Otro resultado inesperado tuvo que ver con los tiempos. La IA tardaba unos segundos más en formular su siguiente pregunta tras la respuesta del niño, debido al proceso de transcripción y generación. Sin embargo, esto no afectó negativamente al desarrollo de la entrevista. De hecho, los investigadores proponen que esta pausa podría haber beneficiado la calidad del recuerdo infantil. Como explican, “Estas pausas naturales podrían haber reducido la carga cognitiva general en la memoria de trabajo de los niños, permitiendo un procesamiento y recuperación de la información más exhaustivos”.

En lugar de apurar la conversación, como suele hacer un adulto por ansiedad o por costumbre, la IA esperó. Y eso, en el cerebro de un niño, puede traducirse en una mejor elaboración de los recuerdos.

¿Un futuro con entrevistadores humanos asistidos por IA?

¿Significa esto que las máquinas deben reemplazar a los entrevistadores humanos? No necesariamente. Lo que plantea el estudio es otra posibilidad: que la IA funcione como asistente en tiempo real, sugiriendo preguntas basadas en las respuestas del niño y ayudando al entrevistador humano a seguir los protocolos adecuados sin desviarse.

El propio autor principal, Pekka Santtila, destaca este punto: “Nuestros resultados indican que la IA podría desempeñar un papel crucial en la mejora de la calidad de las entrevistas a niños al apoyar a los entrevistadores humanos con sugerencias de preguntas en tiempo real".

Esto no solo ayudaría en contextos con falta de formación especializada, sino que podría reducir el sesgo, la fatiga y el desgaste emocional que experimentan los profesionales en entrevistas prolongadas o sensibles.

Lo que la IA no puede (aún) hacer sola

A pesar de los resultados prometedores, el estudio también señala sus límites. El experimento se realizó con niños cooperativos y en un entorno controlado. En situaciones reales —como entrevistas a víctimas de abuso— intervienen factores emocionales, sociales y culturales complejos. Además, la IA no mostró la misma persistencia que los humanos: dejaba de hacer preguntas antes, en cuanto sentía que había reunido suficiente información.

El artículo también advierte que “El LLM no pudo determinar el nivel adecuado de detalle requerido ni cuánto podría un niño ser capaz de elaborar sobre un evento específico”. Por tanto, su aplicación directa en casos reales aún requiere investigación, mejora de modelos y regulación ética.

¿Hacia un protocolo mixto IA-humano?

La IA no sustituye el juicio, la empatía ni la ética del profesional humano, pero puede convertirse en una herramienta potente para apoyar entrevistas infantiles más rigurosas, neutrales y eficaces. Según los autores, en futuras versiones, el sistema podría integrarse mediante tabletas, gafas de realidad aumentada o incluso interfaces de voz, para ofrecer preguntas sugeridas sin interrumpir el curso de la entrevista.

El artículo cierra con una propuesta concreta: “El papel del LLM sería ofrecer sugerencias de preguntas, mientras que el entrevistador humano decidiría de manera autónoma si utilizar la sugerencia, rechazarla o formular otra pregunta en su lugar”.

En otras palabras: la IA pregunta, pero la decisión final sigue siendo humana.

Referencias

- Sun, Y., Pang, H., Järvilehto, L., Zhang, O., Shapiro, D., Korkman, J., Haginoya, S., & Santtila, P. (2025). Comparing the performance of a large language model and naive human interviewers in interviewing children about a witnessed mock-event. PLOS ONE, 20(2), e0316317. https://doi.org/10.1371/journal.pone.0316317.